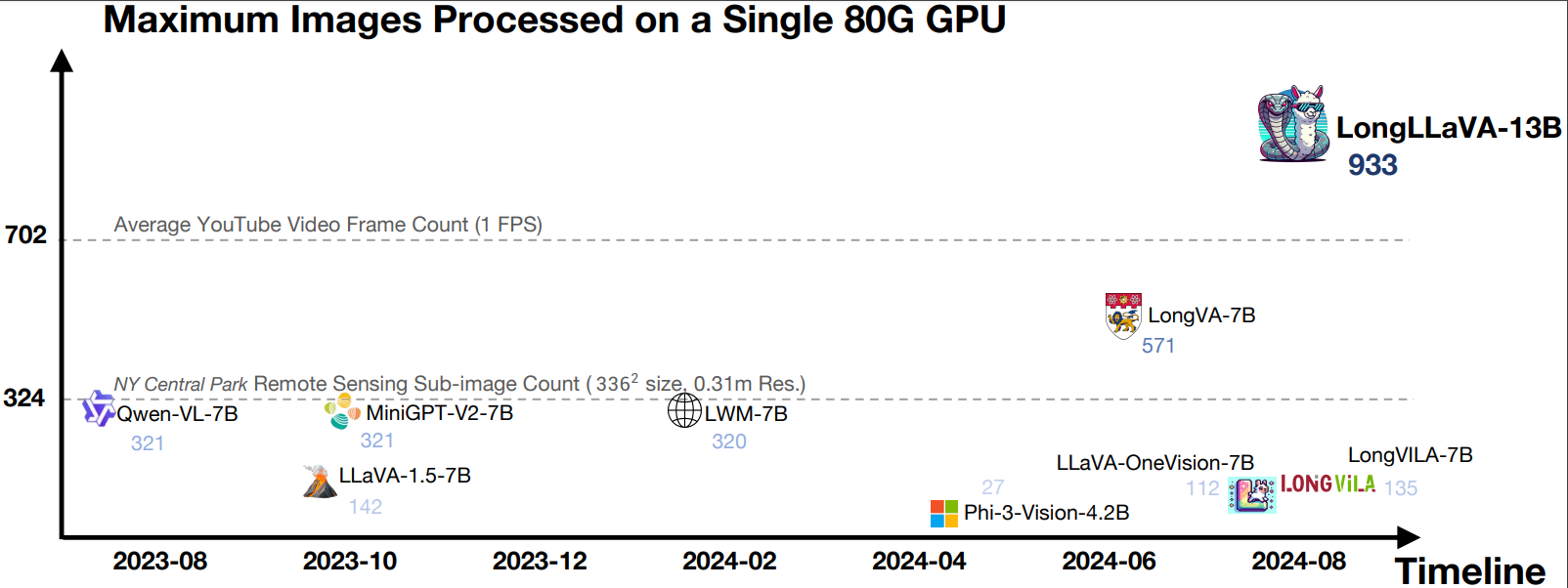

LongLLaVA:通过混合架构将多模态 LLMs 1000 张图像。

LongLLaVA,长上下文的视觉多模态模型,首个采用 Mamba 和 Transformer 混合架构的模型,能在单个 A100 80GB GPU 上处理近千张图像。

Github地址:https://github.com/freedomintelligence/longllava

模型下载地址:https://huggingface.co/FreedomIntelligence/LongLLaVA

论文地址:https://arxiv.org/abs/2409.02889

微信扫描下方的二维码阅读本文

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

评论(0)